почему бывший стартап Илона Маска OpenAI предал свои идеалы — Будущее на vc.ru

Компания хотела стать первой в создании безопасного искусственного интеллекта и выбрала закрытый и коммерческий путь вместо прозрачности и объединения усилий с другими разработчиками. Своё недоверие проекту высказал Илон Маск.

9160 просмотров

За четыре года существования OpenAI стала одной из ведущих исследовательских лабораторий по разработке искусственного интеллекта.

Она сделала себе имя на больших исследованиях, как и DeepMind, принадлежащая Alphabet. OpenAI любят в Кремниевой долине, а среди основателей были Илон Маск и инвестор Сэм Альтман. При запуске стартапа в 2015 году частные инвесторы обещали вложить в компанию $1 млрд.

Логотип OpenAI в офисе MIT Technology Review

Цель OpenAI — стать первым создателем дружелюбного ИИ общего назначения (Artificial general intelligence — AGI), универсальную машину, которая обладает способностью к обучению и рассуждению.

Разработав AGI компания не стремится к мировом господству — в идеалах лаборатории обеспечить безопасное развитие технологии и равномерное распределение её возможностей по всему миру.

Но после трёх дней в офисе OpenAI и почти 30 интервью с бывшими и нынешними сотрудниками, их друзьями и экспертами появился другой взгляд на то, чем занимается и как себя ведёт организация, пишет журналистка MIT Technology Review Карен Хао.

По её мнению, есть несоответствие между публичностью OpenAI и тем, как она работает за закрытыми дверями: при всех благородных мотивах амбиции компании вынудили её создать закрытое подразделение с коммерческими исследованиями, усилить конкуренцию и всё меньше быть открытой, дружелюбной и прозрачной.

Почему OpenAI позиционировала себя открытой и дружелюбной

AGI — универсальная «машина результатов», которая получает определённую задачу и с помощью сенсоров и управляющих элементов выполняет её.

ИИ общего назначения может считаться система, которая справится с любой задачей: от управления беспилотником и ядерным реактором до продажи товаров и написания текстов.

MIT Technology Review пишет, что AGI может легко выйти из-под контроля, если развитие технологии будет идти по пути наименьшего сопротивления: алгоритмы могут быть предвзяты и ненадёжны, а большая стоимость разработки может сконцентрировать власть в руках узкой группы людей.Поэтому создание и распространение AGI может привести к катастрофическим последствиям без осторожного управления доброжелательными создателями.

OpenAI хотела быть этим доброжелательным создателем, и тщательно разрабатывала свой имидж и старалась соответствовать ему.

Например, в области ИИ, где доминируют крупнейшие технологические корпорации, лаборатория OpenAI была некоммерческой — по словам основателей, чтобы создавать ценность для всех, а не только акционеров.

Для OpenAI настолько важно, чтобы AGI был безопасен для общества, что если бы другая компания приблизилась к завершению его разработки, OpenAI не конкурировала бы с ней, а объединила усилия.

Такой добродетельный имидж и заявления компании привлекали внимание СМИ и инвесторов.

Компания заявляла, что миру необходима научно-исследовательская лаборатория, которая может расставить приоритеты, исходя из интересов общества, а не собственных интересов.

Сотрудникам было рекомендовано публиковать свои работы в формате статей, публикаций в блогах и открытого кода, а патенты OpenAI обещала распространять по всему миру. Подтекст был прост: другие лаборатории, такие как DeepMind, не могли служить человечеству, потому что ограничены коммерческими интересами.

Пока они были закрытыми, OpenAI была бы открытой.

От добродетеля к коммерции

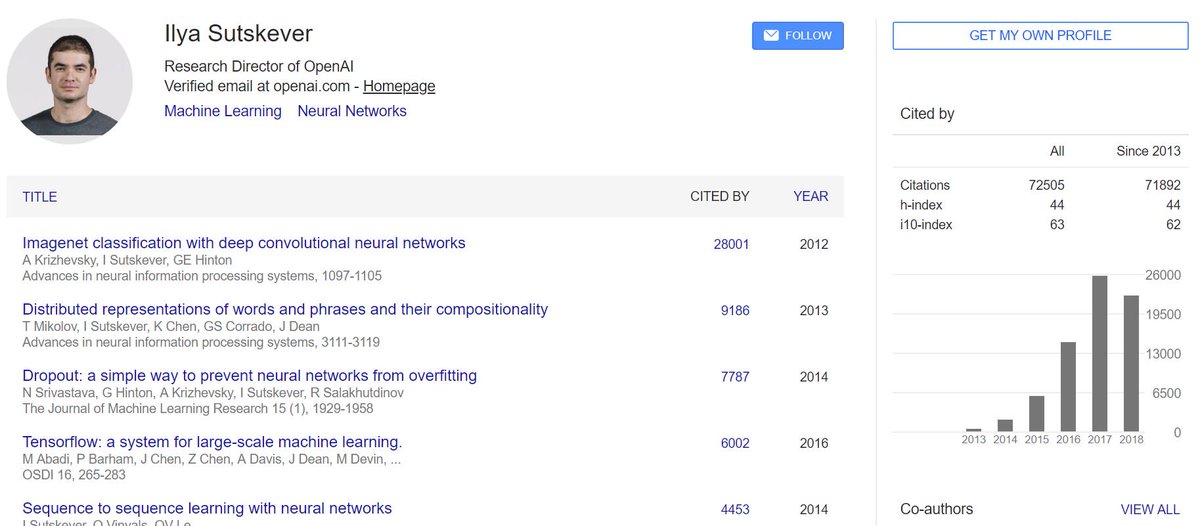

Бывший технический директор платежной системы Stripe Грэг Брокман пришёл на аналогичную должность в OpenAI. Директором по исследованиям стал Илья Сукцевер, ученик «пионера ИИ» Джеффри Хинтона, а семь исследователей были набраны из лучших технологических университетов и компаний.

Директором по исследованиям стал Илья Сукцевер, ученик «пионера ИИ» Джеффри Хинтона, а семь исследователей были набраны из лучших технологических университетов и компаний.

Грэг Брокман Coindesk

Также к OpenAI присоединился исследователь Иэн Гудфеллоу, автор моделей генеративных сетей, книг по глубокому обучению и сотрудник лаборатории Google Brain.

Команда была небольшой, формировалась через связи друг с другом, а руководство оставалось свободным и неформальным. OpenAI верила в «плоскую структуру», где любая идея или обсуждение будут приветствоваться всеми.

Но неформальность привела к неопределённости развития. В мае 2016 года к Альтману и Брокману приехал исследователь Google Дарио Амодей и заявил, что никто не понимает, чем занимается OpenAI. Позже он вместе с женой присоединился к команде OpenAI.

В формировании видения OpenAI большую роль сыграл Илон Маск, отмечает профессор Калифорнийского университета Питер Аббил, который в первые два года основания компании работал там со своими учениками.

Маск предполагал, что создание AGI возможно на 0,1–1% в ближайшие пять-десять лет, и просил задуматься об этом, что мотивировало людей, говорит Аббил.

К марту 2017 года, спустя 15 месяцев после основания OpenAI, руководство поняло, что пришло время сфокусироваться на разработке ИИ. Брокман и несколько других членов команды начали составлять внутренний документ, следуя которому будет разрабатываться AGI.

Но в процессе выявился недостаток: команда изучила возможности и поняла, что оставаться некоммерческой организаций нецелесообразно с финансовой точки зрения. Вычислительные ресурсы, которые использовали другие исследователи в области ИИ для достижения прорывных результатов, удваивались каждые три-четыре месяца.

Брокману стало ясно: команде нужно достаточно денег, чтобы разработки оставались актуальными — соответствовали росту вычислительной мощности или превосходили её.

Для этого потребовалась новая организационная модель, которая могла бы быстро получать деньги, но при этом соответствовать идеалам миссии OpenAI.

Команда OpenAI MIT Technology Review

Без ведома общественности и большинства сотрудников OpenAI выпустила обновлённый устав в апреле 2018 года. В документе были сформулированы основные ценности лаборатории, но формулировки были более расплывчатые — они отражали новую реальность, в которой OpenAI становилась коммерческой.

В документе были сформулированы основные ценности лаборатории, но формулировки были более расплывчатые — они отражали новую реальность, в которой OpenAI становилась коммерческой.

Кроме обязательства избегать чрезмерного использования ИИ или AGI, которые могут нанести вред человечеству, или сосредоточить власть в одних руках, OpenAI подчеркнула необходимость в деньгах.

«Мы ждём, что для выполнения нашей миссии нам потребуются значительные ресурсы. Но мы всегда будем действовать так, чтобы свести к минимуму конфликты интересов среди сотрудников и заинтересованных сторон, которые могут поставить под угрозу выгоду общественности», — говорилось в документе.

Изменение структуры произошло в марте 2019 года. OpenAI лишилась статуса некоммерческой организации. Она открыла коммерческое подразделение OpenAI LP, в котором установило для инвесторов возможность получить ограниченную 100-кратную прибыль от их вложений.

OpenAI лишилась статуса некоммерческой организации. Она открыла коммерческое подразделение OpenAI LP, в котором установило для инвесторов возможность получить ограниченную 100-кратную прибыль от их вложений.

Коммерческой структурой управлял тот же совет директоров, что и у материнской некоммерческой лаборатории.

Вскоре после этого OpenAI объявила о получении инвестиций в размере $1 млрд от Microsoft, при этом не разъяснив, какая часть инвестиций в денежной форме, а какая — в деньгах на счете облачной платформы Microsoft Azure.

Гендиректор OpenAI Сэм Альтман и глава Microsoft Сатья Наделла Microsoft

Шаг с 100-кратным возвратом инвестиций вызвал волну критики. Например, на форуме Hacker News пользователи задались вопросом, можно ли ограничить стократное ограничение.

Например, на форуме Hacker News пользователи задались вопросом, можно ли ограничить стократное ограничение.

Ранние инвесторы в Google получили примерно 20-кратную прибыль, вы заявляете, что создадите корпоративную структуру, которая вернёт на порядок больше денег, чем Google, но при этом не хотите «чрезмерно концентрировать власть». Как это сработает? Что такое власть, если не концентрация ресурсов?

Как вы сможете заработать достаточно денег, чтобы вернуть инвестиции в большем размере, чем любая другая компания, при этом без конфликта интересов между сотрудниками и заинтересованными сторонами? Самые ценные компании в мире в то же время одни из самых спорных — взгляните на Facebook, Amazon и Google.

из обсуждения Hacker News

В ответ на это Брокман заявил, что если OpenAI создаст AGI, то сможет заработать больше, чем любая существующая компания.

Изменения также напугали сотрудников, которые выразили аналогичные опасения. Чтобы успокоить их, руководство написало памятку, в которой, например, утвердительно ответила на вопрос «Могу ли я доверять OpenAI» с большим разъяснением.

Устав OpenAI больше похож на религиозные писания, которое объясняет каждый аспект существования компании и заставляет безоговорочно следовать ему, отмечает журналистка MIT Technology Review.

Например, руководство ссылается на устав, когда отвечает, как OpenAI будет конкурировать за то, чтобы первой создать безопасный AGI, или равномерно распределять его возможности в обществе: «Наш лучший шанс (быть первыми) — это то, что есть в уставе».

Жёсткая привязка к документу работает: все сотрудники объединены общей целью с единой культурой и относятся к исследованиям ИИ не просто как к работе. Они постоянно разговаривают о работе, даже во время обеда, ходят на одни и те же мероприятия, изучают философию «эффективного альтруизма» и шутя описывают свою жизнь терминами искусственного интеллекта.

Но в середине 2019 года, вскоре после перехода к коммерческой основе, руководство ввело новую структуру оплаты труда, частично основанную на «миссии сотрудника». Кроме пунктов «инженерная экспертиза» и «направление исследований», в таблице карьерной лестницы появилась колонка «уровней» сотрудника , связанная с уставом.

Для достижения третьего уровня нужно «понимать и усваивать устав OpenAI», на пятом уровне — «гарантировать, что все личные проекты и проекты коллег соответствуют уставу», а на седьмом — «нести ответственность за соблюдение и улучшение устава, а также за то, чтобы другие члены организации тоже несли за это ответственность».

Неудачный запуск и критика генератора текстов GPT-2

14 февраля 2019 года OpenAI объявила о создании модели GPT-2, которая может генерировать качественные эссе и тексты с помощью одного вступительного предложения. Исследователи лаборатории заявили, что GPT-2 слишком опасна, чтобы её выпускать, назвав её силой, которую легко использовать для дезинформации в огромных масштабах.

Двусмысленное заявление вызвало критику учёных, часть которых заявила, что GPT-2 лишь рекламный ход: модель либо недостаточно развита, чтобы представлять угрозу, либо заявление OpenAI о существовании мощной модели и препятствование общественному контролю бессмысленно.

«Казалось, что OpenAI пытается извлечь выгоду из паники вокруг ИИ», — заявил доцент Рутгерского университета, Бритт Пэрис, изучающий дезинформацию, сгенерированную ИИ.

Демонстрация OpenAI GPT-2

В мае 2019 года OpenAI пересмотрела позицию и объявила о планах «поэтапного релиза». Стартап в течение нескольких месяцев публиковал всё более мощные версии GPT-2 и сотрудничал с исследовательскими лабораториями, чтобы изучить возможности злоупотребления алгоритмами и разработать контрмеры.

В ноябре 2019 года OpenAI опубликовала полную версию GPT-2, заявив, что нет веских доказательств злоупотреблений, а анонс не был рекламным ходом.

По словам представителей лаборатории, это был тщательно продуманный эксперимент, согласованный после внутренних обсуждений — и если даже они перегнули палку, это создало бы прецедент для более опасных исследований.

Более того, в уставе предсказывалось, что соображения безопасности постепенно вынудят лабораторию сократить традиционные публикации в будущем.

Тем не менее принцип анонса и распространения GPT-2, а также объяснения в блоге о безопасности не убедили научное сообщество: по мнению критиков OpenAI, компания преувеличивает шум вокруг своей деятельности и интерпретирует результаты в свою пользу до полного искажения.

Более того, ИИ-сообщество связало изначальную закрытость GPT-2 с переходом OpenAI на коммерческую основу и предположило, что таким образом компания хочет сохранить в тайне технологию, чтобы впоследствии лицензировать её.

По этим причинам многие ученые в области ИИ решили держаться подальше от компании, заявляет MIT Technology Review.

Во внутренних документах лаборатории указано, что OpenAI должна рассматриваться как самый перспективный проект в области машинного обучения и создания AGI, чтобы влиять на политику на государственном уровне, а для этого нужна широкая поддержка со стороны научного сообщества.

Из-за скандала с GPT-2 в OpenAI начались внутренние обсуждения, как исправить положение, так как внешняя критика привела к потере доверия сотрудников и проблемам с наймом лучших на рынке специалистов. Для решения проблемы компания решила изменить тон и формат публикаций и относиться к научному сообществу как к заинтересованной стороне.

Повышенная секретность, закрытые исследования и новый проект OpenAI

Существует две теории о том, как можно создать AGI, пишет MIT Technology Review. В одной из них все необходимые методы уже существуют и нужно просто выяснить, как их собрать и масштабировать. В другой есть мнение, что для AGI нужно придумать совершенно новую парадигму (мышления ИИ), а основной на данный момент технологии глубокого обучения будет недостаточно.

В другой есть мнение, что для AGI нужно придумать совершенно новую парадигму (мышления ИИ), а основной на данный момент технологии глубокого обучения будет недостаточно.

Большинство исследователей колеблются между этими вариантами, но OpenAI уже сделала свой выбор — большинство её научных прорывов получены благодаря использованию больших вычислительных мощностей в технических инновациях, разработанных другими лабораториями.

Брокман и другие сотрудники отрицают, что это единственная стратегия OpenAI, но исследования лаборатории говорят об обратном.

Команда OpenAI под названием «Предвидение» проводит эксперименты, с помощью которых проверяет, насколько сильно они могут улучшить возможности ИИ, обучая существующие алгоритмы всё большим объёмом данных и увеличивая вычислительную мощность.

Результаты экспериментов подтвердили идею руководства, что лучшая стратегия — наращивать вычислительную мощность в уже существующих технологий, а не разрабатывать что-то принципиально новое.

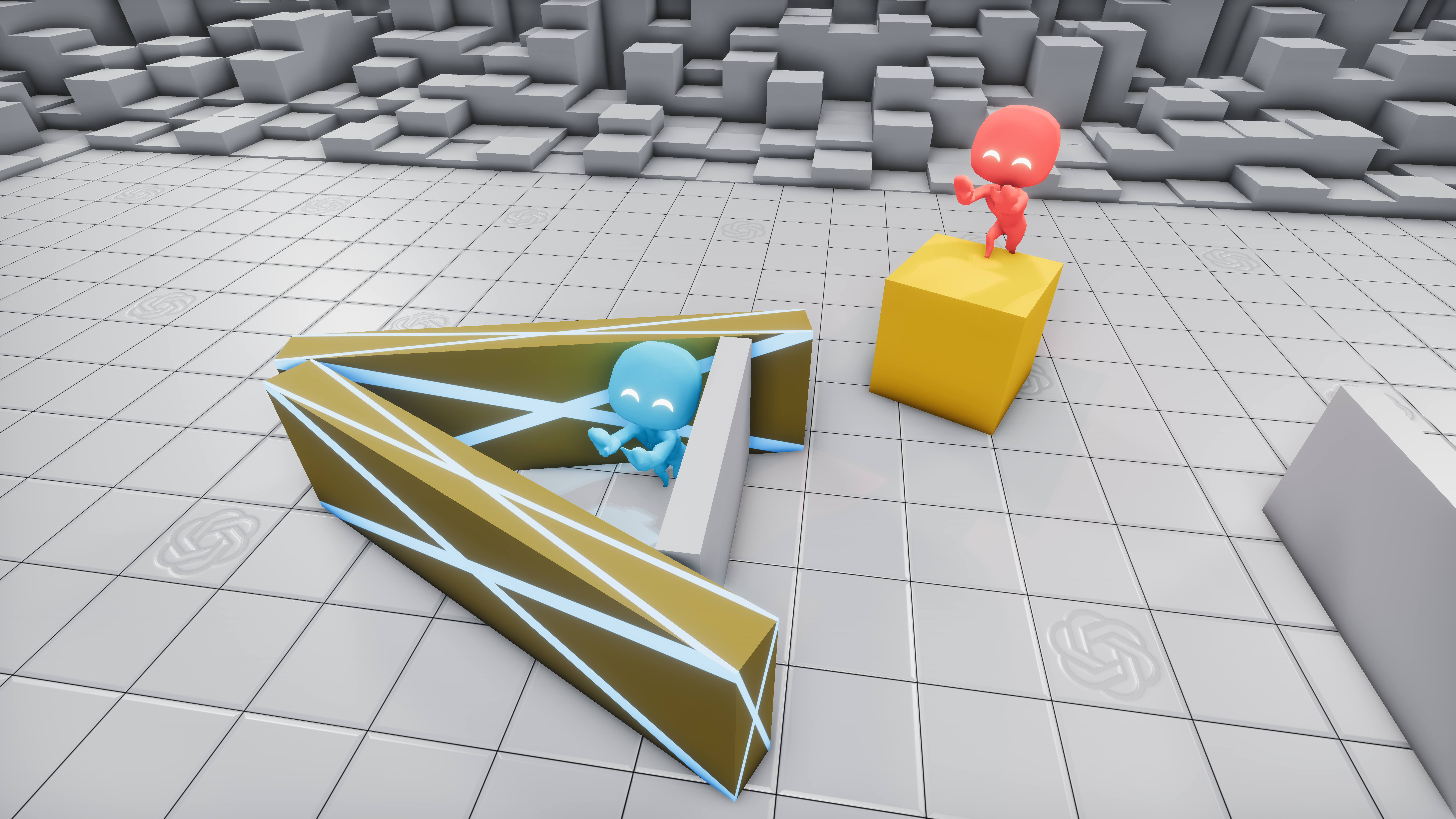

Команда OpenAI и команда по Dota 2 OG — на соревнованиях ИИ против киберспортсменов

OpenAI скрывала результаты от общественности на протяжении полугода, так как считала их своим основным конкурентным преимуществом, пишет MIT Technology Review. Сотрудникам и стажёрам было дано указание не раскрывать их, а тем, кто уволился, нужно было подписать соглашение о неразглашении.

Только в январе 2020 года команда «без шума» (как OpenAI обычно делает) опубликовала статью в одной из открытых баз данных об исследованиях ИИ. При этом похожая статья со схожими результатами была опубликована другими исследователям несколькими месяцами ранее, отмечает издание.

При этом похожая статья со схожими результатами была опубликована другими исследователям несколькими месяцами ранее, отмечает издание.

Такой уровень секретности в лаборатории не был намерением, но стал привычным, так как руководство отошло от первоначальной веры в то, что открытость — лучший способ создать полезный ИИ общего назначения.

Теперь внутри OpenAI важна тишина, например, сотрудникам запрещено общаться с журналистами без разрешения группы по связям с общественностью, а за скрытность хвалят.

Журналистка MIT Technology Review после нескольких разговоров с сотрудниками получила письмо от начальника отдела по связям с общественностью, в котором было указано, что все запросы должны проходить через него, а сотрудники должны были информировать о разговоре и его темах.

В ответ на обвинения MIT Technology Review в повышенной секретности представитель OpenAI сослался на устав, использовав трактовку о «сокращении публикаций из-за возможных проблем с безопасностью». Он объяснил, что каждая публикация OpenAI проходит через проверку на информационные риски, а результаты публикуются с задержкой, чтобы понять потенциальные риски и последствия исследований.

Один из самых больших секретов OpenAI — их новый проект, который, по словам источников MIT Technology Review, станет «кульминацией предыдущих четырех лет исследований».

Это система искусственного интеллекта, обученная на изображениях, тексте и других данных с использованием огромных вычислительных ресурсов. По мнению руководства, это самый перспективный способ достижения AGI.

По мнению руководства, это самый перспективный способ достижения AGI.

Другие трудности OpenAI: стратегия развития и вопрос распределения технологий

За развитие OpenAI отвечает директор по исследованиям — бывший сотрудник Google Дарио Амодей. По его словам, стратегия лаборатории делится на две части.

Дарио Амодей MIT Technology Review

В первой части лаборатория изучает, как можно расширить возможности ИИ — он называет её «инвестиционным портфелем».

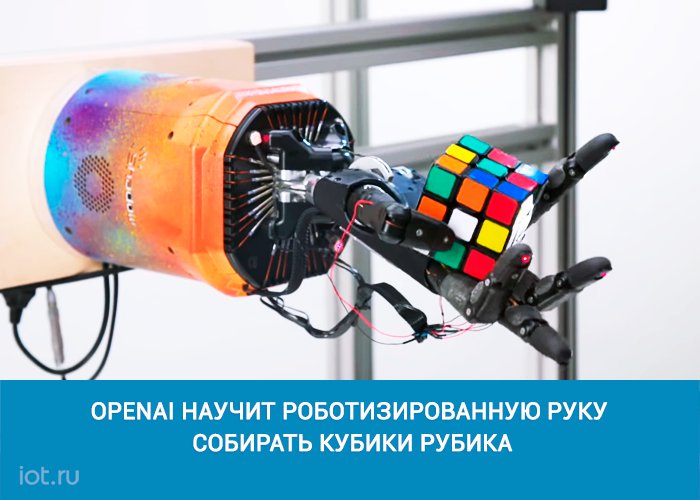

OpenAI выделяет деньги командам для изучения разных направлений развития: например, языковая команда проверяет теорию, по которой ИИ может лучше понимать мир через изучение языков. Команда робототехники, напротив, считает, что для развития ИИ нужно физическое воплощение, и проверяет гипотезу.

Как и в портфеле инвестора, каждое направление имеет свой вес, но в целях научной строгости любую теорию нужно тщательно проверить, прежде чем отказаться от неё. Например, несмотря на первоначальный скепсис о GPT-2 с генерируемыми реалистичными текстами, это направление может считаться многообещающим.

По мере того, как будет меняться приоритет направлений, в перспективные будет направлено больше инвестиций и сотрудников, а оставшиеся будут пересекаться и объединяться. Конечная цель эксперимента — по мере объединения команд создать единое техническое направление для создания AGI, и этот процесс уже начался в последнем секретном проекте OpenAI.

Конечная цель эксперимента — по мере объединения команд создать единое техническое направление для создания AGI, и этот процесс уже начался в последнем секретном проекте OpenAI.

Робот OpenAI собирает кубик Рубика

Вторая часть стратегии посвящена тому, как обезопасить постоянно развивающийся ИИ. Это включает в себя отражение в ИИ человеческих ценностей, объяснение логики своих решений и возможность обучаться, не причиняя вред людям в процессе принятия решений.

Для каждой цели есть отдельная команда разработчиков методов, которые можно будет интегрировать в проекты по мере их развития. Например, объяснение логики решений может быть использовано для раскрытия способов формулировки предложений в GPT-2 или движений робота.

Амодей признает, что часть стратегии бессистемна и построена больше не на теориях, а на интуитивных предположениях.

Мы находимся в неловком положении, так как не знаем, как может выглядеть полезный ИИ и когда он появится. Разум любого человека ограничен, лучшее, что я могу сделать, — нанять других исследователей, мысли которых отличаются от того, что я могу придумать.

Дарио Амодей

директор по исследованиям OpenAI

Ещё одна проблема — неясно, как компания планирует «распределять ценности AGI всему человечеству», основную миссию, которую цитирует Брокман. В основном руководство лаборатории говорит в обтекаемых терминах и предпринимает мало конкретных действий.

В основном руководство лаборатории говорит в обтекаемых терминах и предпринимает мало конкретных действий.

Подразделение робототехники OpenAI

В январе 2020 года Институт будущего человечества в Оксфордском университете опубликовал совместный с OpenAI доклад, в котором предлагалось распределять «ценности» через распределение части прибыли.

Но при этом авторы ссылались на «существенные нерешенные вопросы, касающиеся того, как это будет реализовано». Для некоторых бывших сотрудников недосказанность стала самой большой проблемой OpenAI.

«OpenAI использует сложные технические приёмы, чтобы заявить о решении социальных проблем, связанных с ИИ, но у неё нет возможности понять их. OpenAI считает, что это выгодное место для своего позиционирования», — говорит представитель Ратгерского университета Бритт Пэрис.

OpenAI считает, что это выгодное место для своего позиционирования», — говорит представитель Ратгерского университета Бритт Пэрис.

Брокман согласен, что для выполнения миссии OpenAI потребуются как техническая, так и социальная экспертизы. Но он не согласен, что социальные вопросы должны решаться с самого начала: «Сначала нужно понять, как будет выглядеть AGI, а затем настанет время убедиться, что мы понимаем последствия».

Быть быстрее всех

В разговоре с сотрудниками о стратегии на 2020 год Альтман ясно дал понять: OpenAI нужно зарабатывать деньги, чтобы заниматься исследованиями, а не наоборот. По словам руководства лаборатории, это трудный и необходимый компромисс, на который пришлось пойти из-за отсутствия богатых инвесторов-филантропов.

По словам руководства лаборатории, это трудный и необходимый компромисс, на который пришлось пойти из-за отсутствия богатых инвесторов-филантропов.

Но на компромисс пришлось пойти не только потому что у OpenAI не хватает денег, но и из-за своих амбиций. OpenAI сделала стратегический выбор создать дружелюбный ИИ общего назначения раньше других, и из-за этого усилилось давление коммерциализации, считает MIT Technology Review.

Давление заставляет принимать решения, которые всё дальше и дальше отодвигают компанию от первоначального замысла.

Она склоняется к шумихе, чтобы привлечь инвестиции и таланты, защищает свои исследования в надежде сохранить превосходство и выбрала сложную стратегию по наращиванию вычислительной мощности — не потому что считает её единственно верной, а потому что она кажется самой быстрой на пути к цели.

Тем не менее в OpenAI по-прежнему занимаются передовыми исследованиями талантливые учёные, мечтающие работать на благо человечества. У неё есть самые важные компоненты и ещё есть время измениться, заключает MIT Technology Review.

Илон Маск вышел из совета директоров OpenAI в феврале 2018 года из-за возможного конфликта интересов с Tesla, использующей машинное обучение для создания автопилота.

Он прокомментировал материал MIT Technology Review в Twitter и заявил, что теперь не имеет контроля в компании, а его понимание действий руководства ограничено. Маск отметил, что любой разработчик искусственного интеллекта, включая Tesla, должен находиться под внешним контролем.

По моему мнению, OpenAI должна быть более открытой.

Все организации, которые разрабатывают продвинутый ИИ должны быть зарегулированы, включая Tesla.

Маск согласился с опасениями о смене направления и принципов OpenAI. По его словам, компания должна быть более открытой, а доверие к директору по исследованием Дарио Амодею у него невелико, когда речь идёт о создании безопасного ИИ.

Искусственный интеллект с компьютерным зрением OpenAI можно обмануть рукописными заметками

Исследователи из лаборатории OpenAI обнаружили, что их современный искусственный интеллект с функцией компьютерного зрения легко обмануть, используя для этого всего лишь блокнот и ручку. Об этом пишет The Verge.

Об этом пишет The Verge.

Достаточно всего лишь приклеить бумажку с неверной подписью объекта, чтобы заставить программу неправильно идентифицировать предмет. Исследователи OpenAI назвали это явление «типографской атакой».

Это может представлять реальную опасность для систем, полагающихся на машинное зрение. Например, таким способом можно обмануть программное обеспечение в беспилотных автомобилях Tesla, чтобы они без предупреждения поменяли полосу движения. Потенциально, это также может принести серьёзную угрозу для множества приложений искусственного интеллекта, от медицинских до военных.

Но в данном случае не о чем беспокоиться, так как речь идёт об экспериментальной системе CLIP, которая пока ещё не используется ни в одном коммерческом продукте.

Новые нейросети OpenAI способны создавать изображения по запросу и определять объекты на фото

В OpenAI разработали две новые нейросети.

CLIP наглядно демонстрирует, как системы искусственного интеллекта учатся определять объекты из огромных баз данных, состоящих из множества пар изображение-текст. Исследователи OpenAI обнаружили отдельные компоненты в сети машинного обучения, которые реагируют не только на изображения объектов, но также на эскизы, рисунки и связанный с ними текст. Они назвали это «мультимодальными нейронами». Согласно исследованиям OpenAI, системы искусственного интеллекта усваивают знания таким же способом, как это делают люди.

Исследователи OpenAI обнаружили отдельные компоненты в сети машинного обучения, которые реагируют не только на изображения объектов, но также на эскизы, рисунки и связанный с ними текст. Они назвали это «мультимодальными нейронами». Согласно исследованиям OpenAI, системы искусственного интеллекта усваивают знания таким же способом, как это делают люди.

В будущем это может привести к созданию более сложных систем технического зрения, но сейчас такие подходы находятся в зачаточном состоянии. В то время, как любой человек может отличить яблоко от листа бумаги с написанным на нем словом «яблоко», искусственный интеллект пока ещё на это не способен. Та же способность, которая позволяет программе связывать слова и изображения на абстрактном уровне, создаёт эту уникальную ошибку, которую в OpenAI назвали «заблуждением абстракции».

Ещё один пример — ошибка при распознавании копилок. ИИ реагирует не только на их изображения, но и на цепочку символов с изображением доллара. То есть, если любой предмет подписать «$$$», то CLIP определит его как копилку.

Заглавная фотография: Гор Хачатрян / Код Дурова

Проект профессора ИТМО стал официальным партнером компании OpenAI, основанной Илоном Маском

Профессор ИТМО Александр Фарсеев и его коллеги получат доступ к нейросети GPT-3, которая умеет создавать контент, практически неотличимый от творчества человека. Команда будет использовать возможности GPT-3 для улучшения рекламных алгоритмов в соцсетях.

Социальные сети являются не только местом для общения, но и крупной рекламной площадкой. Только за первые три месяца 2020 года Facebook получил от рекламы 17,44 млрд долларов. Это неудивительно, ведь соцсети позволяют найти индивидуальный подход к пользователю и давать ему информацию о тех товарах, которые ему, скорее всего, нужны.

Чтобы пользоваться этими возможностями, брендам приходится постоянно создавать новые рекламные тексты. Более того, необходимо делать разные варианты публикаций об одном и том же товаре для отдельных групп пользователей. Это требует от компаний больших усилий и больших затрат.

Более того, необходимо делать разные варианты публикаций об одном и том же товаре для отдельных групп пользователей. Это требует от компаний больших усилий и больших затрат.

Источник: shutterstock.com«Бренды тратят огромные ресурсы на креативные команды, которые занимаются написанием текстов, маркетологи хотят менять контент каждые три-четыре дня, при этом он должен быть разным. Это большие усилия, которые не всегда оправдываются. Только в Facebook в прошлом году было потрачено более 15 млрд долларов на неэффективную рекламу», — рассказывает руководитель Media Research Group лаборатории машинного обучения Университета ИТМО Александр Фарсеев.

Александр Фарсеев развил наработки лаборатории машинного обучения для создания проекта SoMin.AI, которая использует искусственный интеллект в маркетинге. Компания вошла в программу акселератора Университета ИТМО. Сейчас она работает над генератором рекламного контента для соцсетей. В 2021 году команде удалось заключить соглашение с OpenAI. Американская компания была основана в 2015 году при участии Илона Маска для того, чтобы разрабатывать новые технологии искусственного интеллекта.

В 2021 году команде удалось заключить соглашение с OpenAI. Американская компания была основана в 2015 году при участии Илона Маска для того, чтобы разрабатывать новые технологии искусственного интеллекта.

«Они изначально были исследовательской группой, затем стали монетизировать свои решения, — рассказывает Александр Фарсеев. — Одной из наиболее известных их разработок является модель искусственного интеллекта третьего поколения GPT-3 с миллиардами параметров. Особенно хорошо она научилась генерировать текстовый контент, практически как человек. Было несколько статей о GPT-3, которые вы читали и только в конце узнавали, что ее написала сама GPT-3. То есть современный искусственный интеллект дошел до того, что может генерировать контент с таким же качеством, что и человек».

GTP-3 написала несколько вариантов эссе о том, почему люди не должны бояться роботов. Из них был скомпилирован текст, который опубликовала The Guardian. В конце 2020 биолог Александр Панчин опубликовал свою беседу с GPT-3, посвященную таким темам, как смысл жизни, лженаука и старение.

В конце 2020 биолог Александр Панчин опубликовал свою беседу с GPT-3, посвященную таким темам, как смысл жизни, лженаука и старение.

Доступом к GPT-3 располагает ограниченное число компаний и исследовательских университетов. Все они имеют возможность использовать нейросеть для своих проектов, которые проходят жесткий отбор. После этого ученые и бизнесмены могут применять творение OpenAI для своих целей, в обмен предоставляя разработчику обратную связь и данные своих исследований. SoMin.AI будет адаптировать GPT-3 для генерации рекламного контента.

SoMin.AI. Источник: somin.ai«Маркетологи смогут создавать только изначальную версию контента, а модели GPT-3 будет создавать на ее основе сотни вариантов, предназначенных для конкретных категорий пользователей и для постоянного обновления рекламных публикаций, — уточняет Александр Фарсеев. — Для этого алгоритмы будут адаптированы лабораторией машинного обучения ИТМО и SoMin.

AI. Имея такое количество контента, Facebook или Google смогут проверять, кому конкретно тот или иной вариант понравится. Это сделает рекламу более эффективной. Команде OpenAI понравилось наше предложение, они нам дали доступ к GPT-3. Сейчас мы все тестируем и в ближайший месяц будем выпускать первую коммерческую бета-версию продукта».

Работа с OpenAI является не только частью коммерческого проекта SoMin.AI, но и должна помочь в исследованиях лаборатории машинного обучения Университета ИТМО. В частности, сейчас с нейросетью работают студенты и сотрудники Первого неклассического.

Также сам проект, предложенный OpenAI, имеет в своей основе научные разработки команды Университета ИТМО ― сотрудники вуза вместе с коллегами из Сингапура представили эти работы на одной из ведущих конференций WSDM и опубликовали статью о персональной генерации контента.

Перейти к содержаниюOpenAI — SkyNet от Илона Маска.

Разбор

РазборТри закона робототехники Айзека Азимова:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Признайтесь, что с таким быстрым развитием технологий, разработкой квантовых компьютеров и повсеместным использованием нейронных сетей, то вы и мы в последние годы ждем уже появления SkyNet?

А может быть вы наоборот считаете, что до реального искусственного интеллекта еще так далеко и что нам, на нашем веку, можно вообще не беспокоиться. Ведь для реальной интеллектуальной деятельности машин нужны гораздо большие вычислительные мощности!

Сегодня, на примере еще одного стартапа Илона Маска, под названием OpenAI, мы с вами посмотрим насколько далеко от нас реальный SkyNet и расскажем вам о том, в каком состоянии находится разработка ИИ в принципе прямо сейчас.

Сегодня мы с вами узнаем может ли робот написать симфонию или нарисовать шедевр?

Что такое ИИ?

Для начала давайте поймем, что такое искусственный интеллект?

Согласно одному из определений — это искусственно созданная система, которая может решать творческие задачи, способна к саморазвитию, самопостроению и самоулучшению себя и себе подобных.

В принципе само понятие ИИ — это скорее философское понятие. Мы никогда не увидим громких заголовков, вроде “Изобретён Искусственный Интеллект!”, человечество будет идти к нему медленно, но уверенно.

К сожалению, нет абсолютно точного определения, что такое искусственный интеллект, но есть тест. Знаменитый тест Алана Тьюринга, который он описал в 1950 году в философском журнале Mind. Суть теста заключается в том, что человеку и компьютеру задаются различные вопросы, а третий человек слушает их ответы. Главное, что человек слушающий ответы не знает, кто именно отвечает и, если у компьютера получилось обмануть человека, то считается, что компьютер победил и прошел тест Тьюринга.

Этот тест был впервые пройден компьютером в 2014 году. Специальная программа Eugene, или Женя Густман, с использованием пяти суперкомпьютеров, смогла обмануть 33% собеседников, что превысило необходимые 30% для прохождение порога.

Кстати, тест Тьюринга работает в две стороны. Есть и обратный тест, тест на человека, и его наверняка проходил каждый смотрящий это видео — это знаменитая Captcha — Completely Automated Public Turing test to tell Computers and Humans Apart или по-русски — полностью автоматизированный публичный тест Тьюринга для различения компьютеров и людей.

И казалось бы, тест пройден, вот он искусственный интеллект, но на самом деле все гораздо сложнее.

В общем, есть два подхода к созданию ИИ:

Первый — нисходящий, считайте сверху-вниз, то есть создание, баз знаний и систем, имитирующих реальные психические процессы человека, такие как мышление, рассуждение, эмоции, творчество и так далее.

Второй, который, опять же, знаком большинству из вас: восходящий или снизу-вверх, когда изучаются нейронные сети и так называемые эволюционные вычисления. Создаются простейшие нейронные модели, сочетание которых в итоге моделирует интеллектуальное поведение.

Создаются простейшие нейронные модели, сочетание которых в итоге моделирует интеллектуальное поведение.

Это и есть те самые нейронки, о которых мы уже вам раньше рассказывали! Это именно те самые нейронки, которые занимаются улучшением ваших фотографий и подбором видео в TikTok.

Основная идея в том, что в будущем, объединив множество нейронных сетей, предназначенных для разных целей, можно построить фактически самостоятельно думающий компьютер, уровень самообучаемости и знаний которого будет такой, что он будет саморазвиваться! Это и есть ИИ.

Что сейчас?

О современном состоянии ИИ сказать не просто. Ведь есть множество областей, где нейронные сети и ИИ применяются очень активно. Хорошим примером является автопилот машин Tesla!

А есть области, где только планируется начать активное внедрение, и тут можно вспомнить о медицине. Только подумайте — нейронная сеть, которая может в автоматическом режиме производить анализ результатов и давать советы по лечению, например, обработка рентгеновских снимков или анализы крови!

Вообще за последние пять лет интерес к области искусственного интеллекта вырос более чем в 3 раза, а количество стартапов только в период с 2015 до 2018 год выросло на 113 процентов.

А поскольку это очень активно развивающаяся область, то и количество ежегодных научных публикаций за последние 20 лет выросло раз в 8!

Огромным скачком стало и развитие нейронных модулей в процессорах, и рост инвестиций в эту область огромный!

В общем, вы поняли — развитие области не просто идет, оно летит вверх!

И знаете, что самое интересное? На вопрос героя Уилла Смита о том может ли робот написать симфонию, уже можно ответить — Да, может!

OpenAI

Илон Маск и еще 5 инвесторов в 2015 году организовали стартап под названием OpenAI, основная суть которого была в том, чтобы увеличить контроль над развитием и созданием ИИ.

Основатели OpenAI говорили о ней именно как о некоммерческой организации, которая не связана финансовыми обязательствами акционеров, чтобы исследователи могли сосредоточить свои силы на создании положительного воздействия ИИ на человека.

Сам Маск говорил, что считает ИИ одной из главных угроз человечества и для его лучшего контроля он активно поучаствовал в создании стартапа, который как раз занимается исследованиями в области ИИ.

«Если не можешь победить что-то — возглавь!», судя по всему именно этим они и руководствовались! И их результаты удивляют.

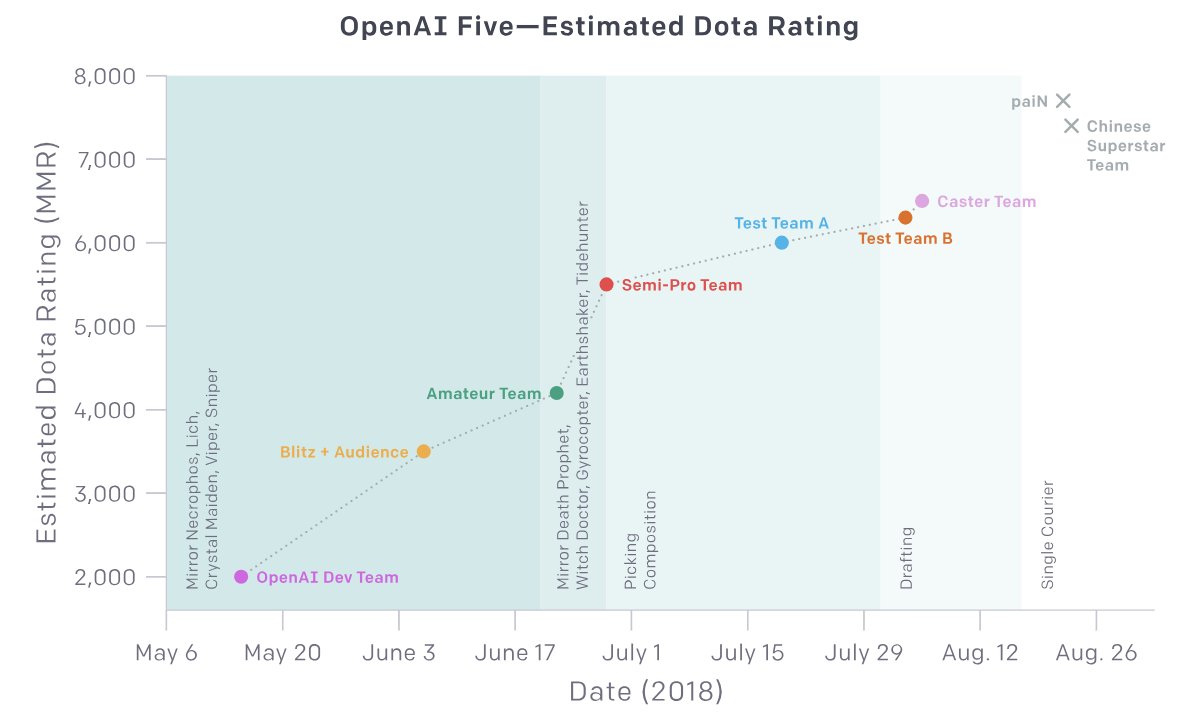

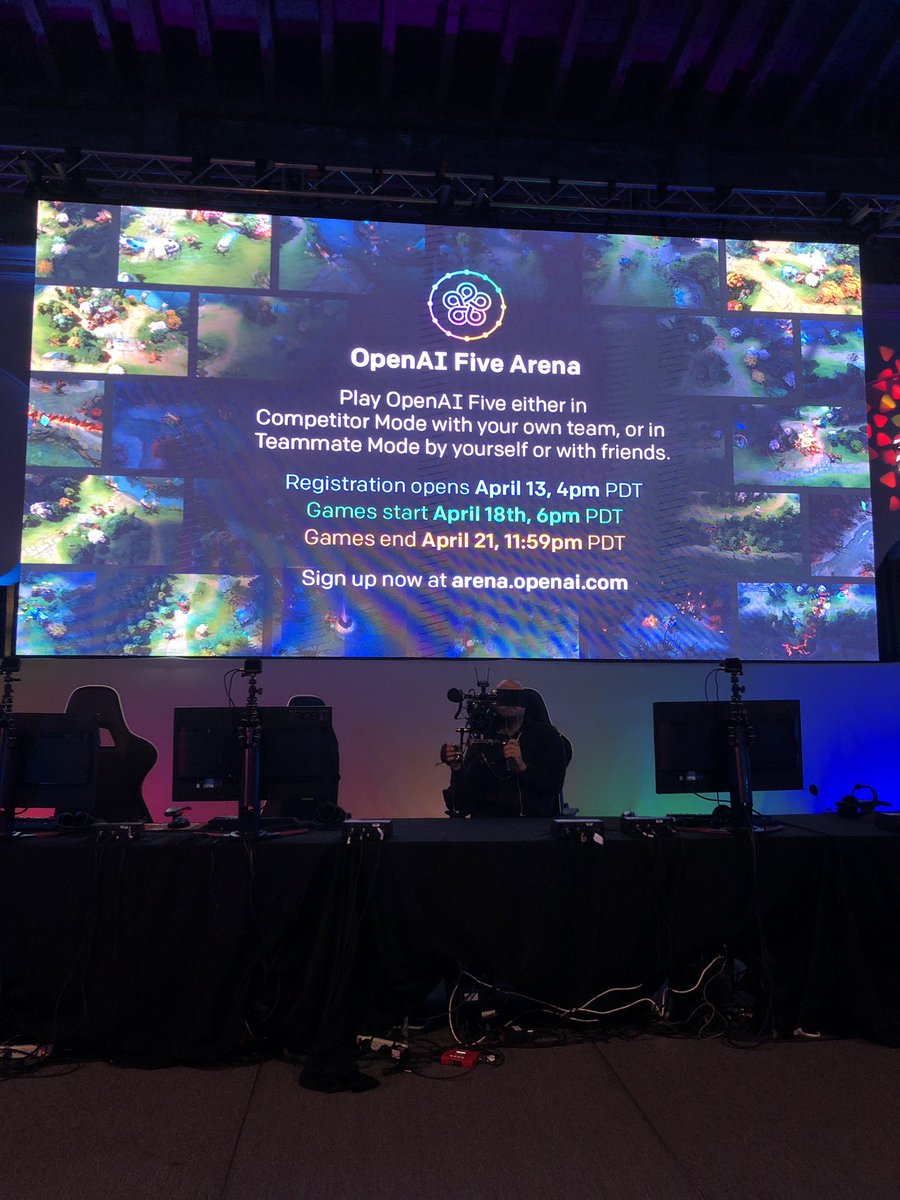

Вы наверное помните новость о том, что нейронная сеть обыграла команду OG, чемпионов International 2018 и 2019 годов в DOTA 2! Так вот эта нейронная сеть была создана командой OpenAI. Билл Гейтс тогда написал, что это очень важное событие, так как игра требует сложного командного взаимодействия.

Всего за время разработки OpenAI представили несколько нейронных сетей. Например, Jukebox — специальная программа, обученная на более чем 1 миллионе песен всех жанров, которая способна самостоятельно писать музыку, осмысленный текст, и даже синтезировать вокал! Так что да — и симфония, написанная машиной, уже возможна!

Только послушайте примеры! В принципе, большинство современных рэп-исполнителей больше не нужны.

А как вам нейросеть DALL·E, которая способна просто по текстовому описанию, рисовать картинки? Она способна сама понимать контекст написанного, например человек задает “a collection of glasses sitting on the table” и давайте посмотрим, что выдает нейронная сеть?

Если переводить с английского, то изначальное описание можно сформулировать двумя вариантами — первый это “набор очков на столе”, и мы видим, что нейронка рисует различные картинки, при этом есть и совсем нереалистичные. Но так же это описание можно перевести и как “набор бокалов на столе”, соответственно нейронная сеть рисует варианты и с бокалами!

Но так же это описание можно перевести и как “набор бокалов на столе”, соответственно нейронная сеть рисует варианты и с бокалами!

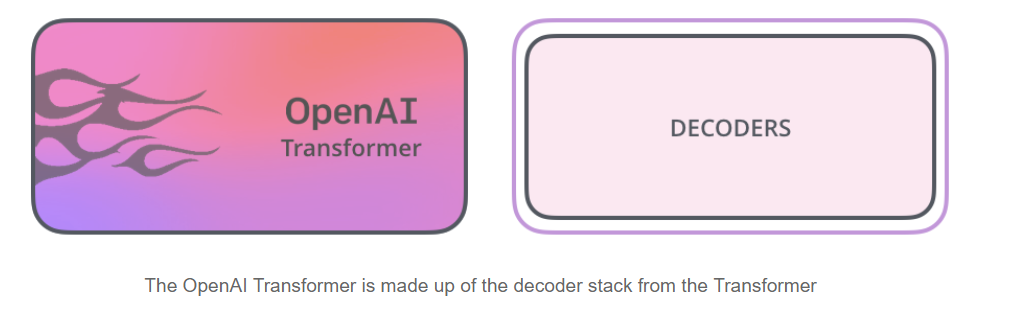

Но как это стало возможным? Все благодаря специальному обучению алгоритма обработки естественного языка, под названием GPT-3. Это третья версия алгоритма представленная в 2020 году. Первая была анонсирована в 2018, для обучения которой была использована текстовая база в 5 Гигабайт, вторая версия спустя год уже изучила 40 гигабайт, а третья использовала базу в 500 ГБ текстов, данных, и 175 миллиардов различных параметров.

И такое количество данных позволяет ей делать уникальные вещи, например, понимать смысл прочитанного, писать большие структурированные тексты или, например, стихи!

Как же это работает?

На входе мы спрашиваем у программы вопрос! То есть мы фактически просим робота понять, что мы только что у него спросили и выдать нам ответ.

Алгоритму мы подаем один пример, где указываем лишь признаки и просим его предсказать, что будет дальше.

В процессе обучения будут ошибки, но внутренние алгоритмы рассчитывают ошибку в предсказании и обновляют нейронку до тех пор, пока ответ не улучшится.

И так несколько миллионов раз. Теперь представим, что наша нейронка уже обучена, то есть она уже скушала эти 500 ГБ текстов, которые взяла из книг и статей в интернете

Далее, после задания вопроса сети, начинаются сложнейшие многоуровневые преобразования. Заданные слова преобразуются в набор цифр и попадают в специальный 96-уровневый декодер, на каждом уровне этот набор чисел проходит через 1,8 миллиарда параметров для вычислений.

Чтобы было чуть более понятно — это авторегрессионная модель, то есть такая модель, которая учитывает результаты предыдущих вычислений и основывается на них на следующем кругу расчетов. И вот пройдя все эти круги в конце выдается ответ, который имеет наименьшую вероятность ошибки на основе предыдущего обучения! Далее выдается ответ.

И вы спросите а какие перспективы? Они огромные. Фактически GPT-3 способна решать любые задачи на английском языке уже сейчас. И не только…

Фактически GPT-3 способна решать любые задачи на английском языке уже сейчас. И не только…

Стоит сказать, что все совсем не так гладко с этой открытостью и светлым будущим ИИ. Дело в том, что Илон Маск покинул проект в 2019 году так как мог возникнуть конфликт интересов. И уже в 2020 году он открыто критиковал подход руководства организации в закрытости и непрозрачности, что, как мы помним, напрямую противоречит принципам заложенным в основе стартапа, да и даже в самом его названии!

А в середине 2020 года произошло что-то совсем странное. Microsoft выкупила эксклюзивные права на тот алгоритм GPT-3, что также подверглось жесткой критике со стороны Маска и сообщества.

Конечно, в самой компании заявили, что это никак не повлияет на доступ независимых разработчиков к GPT-3 через API компании, но определенно все эти новости вызывают недоверие и опасения.

Вывод

В любом случае все это развитие впечатляет. Еще пять лет назад никто и подумать не мог, что телефоны, со своими маленькими матрицами будут способны снимать астрофотографии, так как это делают современные смартфоны Pixel.

А скажите 15 лет назад кому-то, что автомобили самосто смогут самостоятельно безопасно ездить по улицам городов, на вас бы вообще как на сумасшедшего посмотрели!

Сегодня все это уже реальность с развитием нейронных технологий и искусственного интеллекта! И это только начало пути нейронных сетей.

Нам лишь остается верить, что все эти системы будут хорошо контролируемы и защищены от возможных внешних воздействий. Ведь в таких важных вопросах, которые уже непосредственно касаются жизни людей, безопасность и надежность важнее всего.

А как мы с вами знаем даже всесильные три закона робототехники, легко обходятся!

Post Views: 1 553

Освободить искусственный интеллект: OpenAI, безумный план Элона Маска

У политиков и капиталистов есть послеобеденная пятничная традиция: вываливать кучу новостей, чтобы скрыть среди них плохие. Поэтому было немного странно, что Элон Маск, основатель производящей электромобили Tesla, и Сэм Альтман, президент известного инкубатора технологий Y Combinator, представили свою новую компанию на тему искусственного интеллекта в самом конце недельной конференции по ИИ в Монреале в декабре прошлого года.

Илон Маск

Представление OpenAI

Представлению OpenAI в такой поздний час была причина. Не потому что никто не смотрел. А потому что смотрели все. Когда некоторые из самых мощных компаний в Кремниевой долине почуяли, куда ветер дует, они начали предлагать огромные суммы денег только что собранным кадрам OpenAI — исследователям искусственного интеллекта, чтобы удержать этих гениев у себя. В последнюю минуту предложения — некоторые были сделаны на самой конференции — стали настолько большими, что Маску и Альтману пришлось задержать объявление нового стартапа. «Суммы дошли до границы безумия», говорит Войцех Заремба, ученый, который присоединился к OpenAI после стажировок в Google и Facebook и был среди тех, кто получал крупные предложения в одиннадцатом часу вечера.

Сколько долларов означают «границу безумия»? Два года назад, когда рынок новейших технологий машинного обучения начал разогреваться, вице-президент Microsoft Research Питер Ли сказал, что стоимость топ-исследователей ИИ превысила стоимость топ-квотербека в Национальной футбольной лиге — и это при обычных условиях, а не когда самые именитые предприниматели Кремниевой долины пытаются переманивать лучшие таланты. Заремба говорит, что когда OpenAI собрался, ему предлагали в два-три раза больше его рыночной стоимости.

Заремба говорит, что когда OpenAI собрался, ему предлагали в два-три раза больше его рыночной стоимости.

OpenAI не соответствовал этим предложениям. Но предлагал кое-что другое: возможность заниматься исследованиями, направленными исключительно на будущее, а не на продукты и квартальную прибыль, и в конечном итоге разделить большую часть — если не все — исследований между всеми, кто пожелает. Именно так: Маск, Альтман и компания намереваются раздать то, что может стать самой преобразующей технологией 21 века, и раздать ее бесплатно.

Заремба говорит, что предложения на грани безумия на самом деле его оттолкнули — несмотря на огромное уважение к таким компаниям, как Google и Facebook. Он почувствовал, что эти деньги направлялись, чтобы предотвратить создание OpenAI, и это еще больше укрепило его стремление к великодушному стартапу. «Я осознал, — говорит Заремба, — что OpenAI — это лучшее место для меня».

Чувствуете иронию в основе этой истории? Пока крупнейшие в мире технологические компании пытаются удержать своих исследователей с таким же рвением, как команды НФЛ пытаются удержать своих звездных квотербеков, сами исследователи просто хотят делиться наработками. В утонченном мире исследований ИИ самые яркие умы движимы не только циклом следующего продукты или прибылью, либо вовсе ими не одержимы. Они хотят сделать ИИ лучше, а сделать ИИ лучше невозможно, когда ты держишь свои последние наработки при себе.

В утонченном мире исследований ИИ самые яркие умы движимы не только циклом следующего продукты или прибылью, либо вовсе ими не одержимы. Они хотят сделать ИИ лучше, а сделать ИИ лучше невозможно, когда ты держишь свои последние наработки при себе.

На днях OpenAI выпустила первую партию программного обеспечения ИИ, инструментарий для создания систем искусственного интеллекта на базе технологии под названием «обучение с подкреплением» (reinforcement learning) — одной из ключевых технологий, которые привели к созданию AlphaGo, ИИ Google, который удивил мир своими возможностями игры в го. С помощью этого набора инструментов вы можете создавать системы, которые откроют новое поколение роботов, играют в игры Atari и да, обыгрывают чемпионов мира в го.

Все самые свежие новости из мира высоких технологий вы также можете найти в Google News.

Но игрушки — это только начало. OpenAI — это миссия на миллиард долларов, задача которой — толкнуть ИИ настолько далеко, насколько это возможно. В том, как собралась компания и каковы ее планы, можно разглядеть следующую новую волну инноваций. Мы пока не знаем, станет ли OpenAI главным двигателем этих изменений. Но силы, которые обусловили создание этого довольно необычного стартапа, показывают, что новое поколение ИИ не только изменит технологию, но и методы работы над этой технологией.

В том, как собралась компания и каковы ее планы, можно разглядеть следующую новую волну инноваций. Мы пока не знаем, станет ли OpenAI главным двигателем этих изменений. Но силы, которые обусловили создание этого довольно необычного стартапа, показывают, что новое поколение ИИ не только изменит технологию, но и методы работы над этой технологией.

Искусственный интеллект повсюду

Кремниевая долина имеет страсть к преувеличениям. Смело звучащие заявления всегда стоит встречать с долей скептицизма. Но в области искусственного интеллекта действительно происходят изменения. Внутри таких компаний, как Google и Facebook, технологии глубокого обучения уже помогают интернет-сервисам определять лица на фотографиях, распознавать голосовые команды на смартфонах и откликаться на запросы в интернет-поиске. И эта же технология может решать много других задач в будущем. Она может помочь машинам научиться понимать естественный язык — на котором мы, люди, привыкли говорить и писать. Может помочь вывести новую породу роботов, позволить автоматам не только выполнять их задачи, но и обучаться на лету. И некоторые считают, что это в конечном итоге подарит машинам нечто вроде здравого смысла — способность мыслить по-настоящему, как человек.

И некоторые считают, что это в конечном итоге подарит машинам нечто вроде здравого смысла — способность мыслить по-настоящему, как человек.

И вместе с такими обещаниями рождается глубокое беспокойство. Маск и Альтман обеспокоены тем, что если люди смогут создавать ИИ, которые делает великие вещи, они смогут построить ИИ, которые творит ужасное. Они не одиноки в своих страхах. И хотя это может показаться нелогичным, Маск и Альтман также считают, что лучший способ побороть вредоносный ИИ — это не ограничивать доступ к искусственному интеллекту, а расширять его. Именно это стремление приводит к команду молодых и умных идеалистов.

OpenAI появилась однажды вечером прошлым летом в отдельной комнате Rosewood Hotel в Кремниевой долине — высококлассном городском отеле, который буквально находится в центре мира венчурных капиталистов. Элон Маск обедал с Ильей Суцкевером, который тогда работал в Google Brain, компании, занимающейся разработкой глубоких нейронных сетей — систем искусственного интеллекта, которые могут обучаться выполнять задачи, анализируя массивные объемы цифровых данных, включая распознавание фотографий и написание электронных писем, обучаясь по перепискам. Суцкевер был одним из ведущих разработчиков проекта.

Суцкевер был одним из ведущих разработчиков проекта.

Илья Суцкевер

Сэм Альтман, Y Combinator которого помог сложиться таким компаниям, как Airbnb, Dropbox и Coinbase, выступил посредником на этой встрече, собрав несколько исследователей ИИ и молодого, но опытного строителя компаний Грега Брокмана, ранее директора по технологиям в стартапе Stripe, еще одной компании Y Combinator. Это была эклектичная группа. Но у всех была цель: создать лабораторию ИИ нового типа, которая смогла бы работать вне контроля не только Google, но и всех остальных. «Лучшее, что я мог представить себе как задачу, — говорит Брокман, — это двигать человечество в сторону создания настоящего ИИ по безопасному пути».

Маск был там, поскольку давно дружит с Альтманом — и поскольку ИИ имеет решающее значение для будущего его различных предприятий, ну и для будущего в целом. Tesla нуждается в ИИ, если хочет строить самоуправляемые автомобили. SpaceX, другая компания Маска, нуждается в том, чтобы выводить с помощью ИИ людей в космос и сохранять их в целости и сохранности там. Но Маск также является одним из первых (и самых громких), кто предупреждал: однажды человечество может потерять контроль над системами, которые достаточно мощные, чтобы учиться самостоятельно.

Но Маск также является одним из первых (и самых громких), кто предупреждал: однажды человечество может потерять контроль над системами, которые достаточно мощные, чтобы учиться самостоятельно.

Была проблема: очень много людей, достаточно квалифицированных, чтобы решить все эти проблемы, уже работали в Google (а еще в Microsoft, Facebook, Baidu и Twitter). И никто на том ужине не был полностью уверен, что этих исследователей получится заманить в новый стартап, даже если за ним будут Маск и Альтман. И по крайней мере один ключевой игрок был готов покинуть корабль. «Я понимал риски, — говорит Суцкевер, — но также понимал, что это будет интересно попробовать».

Как ученые выходят из тупика

Ободренный разговором с Маском, Альтманом и другими в Rosewood, Брокман вскоре решил построить лабораторию, которую они все задумали. Крепко занявшись проектом, он пригласил Йошуа Бенгио, ученого из Университета Монреаля и одного из отцов-основателей движения глубокого обучения. Два других пионера отрасли — Джефф Хинтон и Ян Лекун — работают в Google и Facebook, соответственно, но Бенгио стремился к жизни в академическом мире, где-нибудь за пределами досягаемости промышленных щупальцев. Он набросал список лучших исследователей в этой области и за несколько следующих недель Брокман связался со всеми, с кем только смог, включая нескольких других.

Два других пионера отрасли — Джефф Хинтон и Ян Лекун — работают в Google и Facebook, соответственно, но Бенгио стремился к жизни в академическом мире, где-нибудь за пределами досягаемости промышленных щупальцев. Он набросал список лучших исследователей в этой области и за несколько следующих недель Брокман связался со всеми, с кем только смог, включая нескольких других.

Многие из этих исследователей приветствовали идею, но с опаской отнесли к возможности такого прыжка. В попытке разорвать круг, Брокман выбрал десять исследователей, которых хотел видеть больше всего, и пригласил провести субботу с вином, закусками и разговорами в винной в долине Напа. Для Брокмана даже поездка в Напа была катализатором проекта. «Это недооцененный способ собирать людей вместе, особенно в те времена, когда вам некуда спешить на пути к своей цели, — говорит он. — Вам нужно туда, но также нужно поговорить». И когда они добрались до вина, эта атмосфера осталась. Как говорит Суцкевер, «вино было вторичным по отношению к беседе».

Грег Брокман

К концу дня Брокман предложил всем десятерым исследователям присоединиться к лаборатории и дал им на раздумья три недели. По истечении срока, девять были в команде. И остались в ней, несмотря на большие предложения от гигантов Кремниевой долины. «Мне сделали очень привлекательное предложение, чтобы я остался, поэтому решение было не из легких, — говорит Суцкевер о Google, его бывшем работодателе. — Наконец, я решил отправиться в OpenAI, отчасти из-за очень сильной группы людей и, конечно, по большей части из-за их миссии».

Подписывайтесь на наш канал в Яндекс Дзен. Там можно найти много всего интересного, чего нет даже на нашем сайте.

Движение глубокого обучения началось с академических кругов. И только недавно компании вроде Google, Microsoft и Facebook решили заняться этой областью, поскольку достижения в области грубой вычислительной силы сделали реальностью эти глубокие нейронные сети, не только теоретической возможностью. Люди вроде Хинтона и Лекуна ушли из академических кругов в Google и Facebook по причине огромных ресурсов в этих компаниях. Но остались тесно связаны в сотрудничестве с другими теоретиками сферы. И все же, как объясняет Лекун, исследования в области глубокого обучения требуют свободного тока идей. «Когда вы проводите исследования в секрете, — говорит он, — вы откатываетесь назад».

Люди вроде Хинтона и Лекуна ушли из академических кругов в Google и Facebook по причине огромных ресурсов в этих компаниях. Но остались тесно связаны в сотрудничестве с другими теоретиками сферы. И все же, как объясняет Лекун, исследования в области глубокого обучения требуют свободного тока идей. «Когда вы проводите исследования в секрете, — говорит он, — вы откатываетесь назад».

Как результат, крупные компании теперь имеют в распоряжении большую часть их исследований ИИ. Это серьезный козырь, особенно для Google, которая и без того давно сохраняет технологии своей онлайновой империи в секрете. Не так давно Google открыла исходный код программного движка, на котором работают ее нейронные сети. Но очень многое остается под замком в этой гонке за будущее. Брокман, Альтман и Маск стремятся продвинуть понятие открытости еще дальше, говоря о том, что не хотят иметь одну или две крупных корпорации, контролирующих будущее искусственного интеллекта.

Пределы открытости

Звучит все это прекрасно. Но при всем идеализме OpenAI, исследователи могут оказаться в тех же условиях, которые вынудили их работать на старых работах. У открытости есть свои пределы. И долгосрочное видение ИИ — не единственный интерес в этой игре. OpenAI не занимается благотворительностью. Компании Маска получат серьезную выгоду от работы стартапа, и компании, работающие на альтмановском Y Combinator, тоже. «Безусловно, имеются некоторые конкурирующие пункты, — говорит Лекун. — Это некоммерческая организация, но у нее есть тесная связь с Y Combinator. И людям будут платить за работу в этой отрасли».

Но при всем идеализме OpenAI, исследователи могут оказаться в тех же условиях, которые вынудили их работать на старых работах. У открытости есть свои пределы. И долгосрочное видение ИИ — не единственный интерес в этой игре. OpenAI не занимается благотворительностью. Компании Маска получат серьезную выгоду от работы стартапа, и компании, работающие на альтмановском Y Combinator, тоже. «Безусловно, имеются некоторые конкурирующие пункты, — говорит Лекун. — Это некоммерческая организация, но у нее есть тесная связь с Y Combinator. И людям будут платить за работу в этой отрасли».

По словам Брокмана, лаборатория не платит те же астрономические зарплаты, которые исследователям ИИ обеспечивали Google и Facebook. Но он также говорит, что лаборатория «хочет хорошо им платить», и предлагает компенсацию в виде опционов акций, сначала в Y Combinator, а позже, возможно, и в SpaceX (которая, в отличие от Tesla, является частной компанией).

Тем не менее Брокман настаивает, что OpenAI не предусматривает особого обращения с родственными компаниями. OpenAI — это исследовательская инициатива, а не консалтинговая фирма. И все же у идеализма OpenAI есть свои ограничения. Компания может и не открывать код всего, что производит, хотя конечной целью является все же распространение большей части произведенного, будь то научные работы или интернет-сервисы. «Работа в открытую не обязательно будет лучшим вариантом. Необходимо взлелеять идею, посмотреть, к чему она приведет, а затем опубликовать, — говорит Брокман. — Мы будем производить много открытого исходного кода. Но у нас также будет много того, что еще не готово к выпуску».

OpenAI — это исследовательская инициатива, а не консалтинговая фирма. И все же у идеализма OpenAI есть свои ограничения. Компания может и не открывать код всего, что производит, хотя конечной целью является все же распространение большей части произведенного, будь то научные работы или интернет-сервисы. «Работа в открытую не обязательно будет лучшим вариантом. Необходимо взлелеять идею, посмотреть, к чему она приведет, а затем опубликовать, — говорит Брокман. — Мы будем производить много открытого исходного кода. Но у нас также будет много того, что еще не готово к выпуску».

Вам будет интересно: Почему спутники Starlink стали невидимыми для человеческого глаза?

Суцкевер также добавляет, что OpenAI может зайти так далеко, что начнет патентовать часть своей работы. «В ближайшее время мы не будем ничего патентовать, — говорит Брокман. — Но мы готовы изменить тактику в долгосрочной перспективе, если посчитаем, что для мира так будет лучше». Например, OpenAI может заняться упреждающим патентованием, чтобы препятствовать другим получать патенты.

Некоторые могут усмотреть в патентах мотив к получению выгоды. Но в этом вся суть патентов.

Проблема сверхинтеллекта

Когда Маск и Альтман представили OpenAI, они также обрисовали этот проект как способ нейтрализовать угрозу злонамеренного искусственного сверхинтеллекта. Конечно, такой сверхинтеллект может вылиться из работы OpenAI, но они настаивают, что любая угроза будет смягчена тем, что технологии будут доступны всем и каждому. «Мы считаем, что намного более вероятно, что великое множество ИИ сможет остановить случайных плохих актеров», говорит Альтман.

Но далеко не все в этой сфере верят в такой исход. Ник Бостром, оксфордский философ, который как и Маск предупреждал об опасностях ИИ, указывает, что если вы делитесь исследованиями без ограничений, «плохие актеры» могут схватить их до того, как все убедятся в их безопасности. «Если у вас есть кнопка, которая делает дрянь в мире, — говорит Бостром, — вы вряд ли захотите дать к ней доступ каждому». Если же, с другой стороны, OpenAI решит придержать исследования, чтобы к ним не получили доступ плохие парни, Бостром спрашивает: а чем это будет отличаться от Google или Facebook?

Может ли искусственный интеллект однажды пойти против человека?

Он говорит, что да, некоммерческий статус OpenAI может изменить положение вещей, а может и не изменить. Реальная сила проекта, говорит он, в том, что он сможет обеспечить проверку Google и Facebook. «Он сможет уменьшить вероятность того, что сверхинтеллект будет монополизирован. Он сможет убрать одну из возможных причин, почему некоторые лица или группы получат доступ к более качественному ИИ, чем все остальные».

Реальная сила проекта, говорит он, в том, что он сможет обеспечить проверку Google и Facebook. «Он сможет уменьшить вероятность того, что сверхинтеллект будет монополизирован. Он сможет убрать одну из возможных причин, почему некоторые лица или группы получат доступ к более качественному ИИ, чем все остальные».

В одной из последних работ философ объясняет, что основной эффект инициативы вроде OpenAI — инициативы свободно делиться своими наработками — состоит в ускорении прогресса искусственного интеллекта, хотя бы в краткосрочной перспективе. И он может ускорить прогресс в долгосрочной перспективе, при условии, что будет соблюден более высокий уровень открытости, чем было бы коммерчески оптимально.

«Может быть и так, что филантропически мотивированный R&D-инвестор мог бы серьезно ускорить прогресс за счет проведения открытой научной политики», говорит он.

В начале января девять исследователей Брокмана собрались в его апартаментах в Сан-Франциско. Проект был настолько новым, что у них даже не было белых досок. (Представьте себе.) Они купили несколько в тот же день и приступили к работе.

Проект был настолько новым, что у них даже не было белых досок. (Представьте себе.) Они купили несколько в тот же день и приступили к работе.

Брокман говорит, что OpenAI начнется с изучения обучения с подкреплением, машинного способа изучения задач за счет их многократного повторения с отслеживанием того, какие методы производят лучшие результаты. Другой основной задачей является так называемое «обучение без учителя» (unsupervised learning) — создание машин, которые действительно могут самообучаться без помощи человека. Сегодня, глубокое обучение зависит от тщательно размеченных данных. Если вы хотите научить нейронную сеть распознаванию фотографий с кошками, вам нужно скормить ей определенное число примеров — и эти примеры должны быть помечены, как фотографии с котами. Такое обучение проводится при помощи людей. Но как и многие другие ученые, OpenAI планирует создавать нейронные сети, которые могут учиться без тщательного отбора данных.

Чтобы не пропустить ничего интересного из мира высоких технологий, подписывайтесь на наш новостной канал в Telegram. Там вы узнаете много нового.

Там вы узнаете много нового.

«Если у вас есть действительно хорошая методика обучения без учителя, машины смогут учиться на всех знаниях в Интернете — как человек, просто глядя по сторонам — или читая книги», говорит Брокман.

Он видит в OpenAI современную инкарнацию Xerox PARC, лаборатории техноисследований, которая существовала в 1970-х годах. Как открытые и свободные исследования PARC дали толчок всему, от графических пользовательских интерфейсов и лазерной печати до объектно-ориентированного программирования, так и Брокман со своей командой хотят нырнуть в то, что раньше было в области научной фантастики. PARC принадлежала Xerox, но кормилась с рук многих других компаний, в том числе и Apple, поскольку люди вроде Стива Джобса приветствовали ее исследования. Брокман хочет, чтобы все приветствовали исследования OpenAI.

В надежде подтолкнуть эту динамику, Брокман и компания привлекли несколько других известных исследователей, включая Яна Гудфеллоу, еще одного старшего научного сотрудника из команды Google Brain. Брокман говорит, что в PARC, по сути, собрали кучу умных людей в месте и решили посмотреть, что будет. «Вам нужно общее видение без центрального контроля».

Брокман говорит, что в PARC, по сути, собрали кучу умных людей в месте и решили посмотреть, что будет. «Вам нужно общее видение без центрального контроля».

Отсутствие контроля важно для идеала. Если привлечь к коллективной цели достаточно людей, конечный результат победит все, что вы стряпали в тайне. Но если ИИ станет таким мощным, как обещалось, уравнение изменится. Нам нужны гарантии, что новообретенный ИИ будет придерживаться тех же эгалитарных идеалов, которые привели к его созданию в первую очередь. Маск, Альтман и Брокман верят в людей, в толпу. И если они окажутся правы, однажды эта толпа станет не полностью из людей.

Искусственный интеллект OpenAI обманули рукописными заметками

10 Марта, 2021, 18:01

3038

Исследователи компании OpenAI, работающие над алгоритмом GPT-3, обнаружили, что искусственный интеллект можно легко обмануть, используя для этого всего лишь блокнот и ручку. Об этом рассказало издание The Verge.

Об этом рассказало издание The Verge.

Эксперимент

Чтобы заставить программу неправильно идентифицировать предмет, ученые приклеили на объект бумажку с неверной подписью. Явление назвали «типографской атакой».

Как отметили в компании, это может представлять реальную опасность для систем, полагающихся на машинное зрение. К примеру, таким способом можно обмануть ПО в автомобилях Tesla — разместив на дороге обманчивые наклейки, электрокар сможет без предупреждения поменять полосу движения. Это также может нести серьезную угрозу для множества приложений, в которых используется искусственный интеллект.

Изображения в материале — The VergeОднако, в данном случае не о чем беспокоиться, уточняют исследователи. Речь идет об экспериментальной системе CLIP, которая еще не используется ни в одном коммерческом продукте.

CLIP предназначен для изучения того, как системы искусственного интеллекта учатся определять объекты из баз данных, состоящих из большого количества пар изображение-текст. Согласно исследованиям, связанным с данным алгоритмом, системы компьютерного зрения усваивают знания таким же способом, как это делают люди. В будущем это может привести к созданию более сложных систем ИИ, но сейчас такие подходы находятся на начальном этапе разработки.

Согласно исследованиям, связанным с данным алгоритмом, системы компьютерного зрения усваивают знания таким же способом, как это делают люди. В будущем это может привести к созданию более сложных систем ИИ, но сейчас такие подходы находятся на начальном этапе разработки.

Интересно также и то, как CLIP реагирует на подписать «$$$» — если любой предмет подписать таким образом, ИИ определит его как копилку.

Напомним, ранее алгоритм GPT-3 научили писать курсовые за 20 минут.

Больше про искусственный интеллект:

Боты Open AI уже побеждают людей 5×5 — Mid or Feed — Блоги

Помните про Open AI Bot?

Того самого, который на TI7 победил Dendi, а до того, в тестовом режиме – Пайкатта, Артизи, Сумаила и прочих?

youtube.com/embed/7U4-wvhgx0w» frameborder=»0″ allow=»autoplay; encrypted-media» allowfullscreen=»»/>

Бота отдали профессионалам для тренировки. И чем серьезнее про относились к новому челленджу, тем сильнее становился самообучающийся бот. Победы над ним стали восприниматься как чудо.

Black уничтожил бота OpenAI. Человечество в безопасности

Мы уже тогда задумались – сможет ли команда Open AI подготовить сильную команду ботов для режима 5×5?

Вот здесь можно подробнее почитать про путь, который прошел бот перед TI7:

От 1,5к MMR до победы над Артизи 10-0. Путь бота на The International

А в особенности интересно вспомнить планы команды разработчиков.

«1 на 1 – это сложный режим, но 5 на 5 – режим титанической сложности. Мы знаем, что придется задействовать все ресурсы искусственного интеллекта, чтобы с ним справиться.

Мы начнем копировать поведение игроков на старте. В доте играется около миллиона матчей в день, реплеи хранятся на серверах Valve две недели. Мы загружали себе каждый реплей экспертного уровня с прошлого ноября, набралось уже 5,8 млн игр (каждая в среднем по 45 минут с 10 игроками). Мы использовали OpenDota, чтобы загрузить эти реплеи и задонатили им 12 тысяч долларов на поддержку проекта».

Мы загружали себе каждый реплей экспертного уровня с прошлого ноября, набралось уже 5,8 млн игр (каждая в среднем по 45 минут с 10 игроками). Мы использовали OpenDota, чтобы загрузить эти реплеи и задонатили им 12 тысяч долларов на поддержку проекта».

Боты уже побеждают людей. И даже бывших про

Да, это реальность.

- Боты справились с полноценной командой людей.

У стака был не самый высокий рейтинг, но боты выглядели ОЧЕНЬ сильно – закончили обе игры в пределах 15 минут.

- Боты справились с сильными игроками под руководством Blitz

Если вы не в курсе, Blitz – английский аналитик, играет в пабах топового уровня, выступал за команду Zephyr.

- Боты пока умеют играть только одной пятеркой героев: Lich, Crystal Maiden, Viper, Sniper, Necrophos

И противостоять – только такой же пятерке. Матчи проводились на зеркальных пиках.

Матчи проводились на зеркальных пиках.

***

Тем не менее, результат впечатляет. Боты не просто принимают верные решения: они научились действовать командно и понимают тонкости макро (захват и контроль карты). В планах разработчиков – матч с «топовыми игроками» уже в июле.

DALL · E: Создание изображений из текста

Прочтите код paperViewDALL · E — это версия GPT-3 с 12 миллиардами параметров, обученная генерировать изображения из текстовых описаний с использованием набора данных из пар текст-изображение. Мы обнаружили, что он обладает разнообразным набором возможностей, включая создание антропоморфных версий животных и объектов, правдоподобное комбинирование несвязанных понятий, визуализацию текста и применение преобразований к существующим изображениям.

Текстовая подсказка

Иллюстрация маленького редиса дайкон в балетной пачке, выгуливающего собаку

Изменить подсказку или просмотреть больше изображений

Текстовая подсказка

кресло в форме авокадо […]

Изменить подсказку или просмотреть больше изображений

Текстовая подсказка

витрина магазина, на которой написано слово «openai» […]

Изменить подсказку или просмотреть больше изображений

Подсказка с текстом и изображением

тот же кот вверху, что и эскиз внизу

Изменить подсказку или просмотреть больше изображений

GPT-3 показал, что язык может использоваться для указания большой нейронной сети выполнять различные задачи по генерации текста. Image GPT показал, что тот же тип нейронной сети также может использоваться для генерации изображений с высокой точностью. Мы расширяем эти результаты, чтобы показать, что манипулирование визуальными концепциями с помощью языка теперь доступно.

Image GPT показал, что тот же тип нейронной сети также может использоваться для генерации изображений с высокой точностью. Мы расширяем эти результаты, чтобы показать, что манипулирование визуальными концепциями с помощью языка теперь доступно.

Обзор

Как и GPT-3, DALL · E — это языковая модель-трансформер. Он получает и текст, и изображение в виде единого потока данных, содержащего до 1280 токенов, и обучается с максимальной вероятностью генерировать все токены один за другим. Эта процедура обучения позволяет DALL · E не только генерировать изображение с нуля, но и регенерировать любую прямоугольную область существующего изображения, которая простирается до нижнего правого угла, в соответствии с текстовой подсказкой.

Мы осознаем, что работа с генеративными моделями может оказать значительное и широкое влияние на общество. В будущем мы планируем проанализировать, как модели, подобные DALL · E, связаны с социальными проблемами, такими как экономическое влияние на определенные рабочие процессы и профессии, возможность предвзятости в результатах модели и более долгосрочные этические проблемы, связанные с этой технологией.

Возможности

Мы обнаружили, что DALL · E может создавать правдоподобные образы для большого количества предложений, исследующих композиционную структуру языка.Мы проиллюстрируем это с помощью серии интерактивных визуальных элементов в следующем разделе. Образцы, показанные для каждой подписи в визуальных эффектах, получены путем взятия 32 лучших из 512 после повторного ранжирования с помощью CLIP, но мы не используем какой-либо ручной выбор вишен, кроме эскизов и отдельных изображений, которые появляются снаружи.

Управляющие атрибуты

Мы проверяем способность DALL · E изменять несколько атрибутов объекта, а также количество его появлений.

Щелкните, чтобы отредактировать текстовое приглашение или просмотреть другие изображения, созданные искусственным интеллектом

пятиугольные зеленые часы.зеленые часы в форме пятиугольника.

по всему миру

Мы обнаружили, что DALL · E может отображать знакомые объекты многоугольной формы, которые иногда маловероятны в реальном мире. Для некоторых объектов, таких как «рамка рисунка» и «тарелка», DALL · E может надежно нарисовать объект любой многоугольной формы, кроме семиугольника. Для других объектов, таких как «крышка люка» и «знак остановки», вероятность успеха DALL · E для более необычных форм, таких как «пятиугольник», значительно ниже.

Для некоторых объектов, таких как «рамка рисунка» и «тарелка», DALL · E может надежно нарисовать объект любой многоугольной формы, кроме семиугольника. Для других объектов, таких как «крышка люка» и «знак остановки», вероятность успеха DALL · E для более необычных форм, таких как «пятиугольник», значительно ниже.Для некоторых визуальных элементов в этом посте мы обнаружили, что повторение подписи, иногда с альтернативными фразами, улучшает согласованность результатов.

куб из дикобраза. куб с текстурой дикобраза.

по всему миру

Мы обнаружили, что DALL · E может отображать текстуры различных растений, животных и других объектов на трехмерных телах. Как и в предыдущем наглядном примере, мы обнаруживаем, что повторение заголовка с альтернативной формулировкой улучшает согласованность результатов.

коллекция очков сидит на столе

по всему миру

Мы обнаружили, что DALL · E может нарисовать несколько копий объекта, когда будет предложено это сделать, но не может надежно считать более трех. Когда предлагается нарисовать существительные, у которых есть несколько значений, например «очки», «чипсы» и «чашки», он иногда рисует обе интерпретации, в зависимости от используемой формы множественного числа.

Когда предлагается нарисовать существительные, у которых есть несколько значений, например «очки», «чипсы» и «чашки», он иногда рисует обе интерпретации, в зависимости от используемой формы множественного числа.

Рисование нескольких объектов

Одновременное управление несколькими объектами, их атрибутами и их пространственными отношениями представляет собой новую проблему.Например, рассмотрим фразу «ёжик в красной шляпе, желтых перчатках, синей рубашке и зеленых штанах». Чтобы правильно интерпретировать это предложение, DALL · E должен не только правильно сочетать каждый предмет одежды с животным, но и формировать ассоциации (шляпа, красный), (перчатки, желтый), (рубашка, синий) и (штаны, зеленый ), не смешивая их. Мы тестируем способность DALL · E делать это для относительного позиционирования, наложения объектов и управления несколькими атрибутами.

маленький красный блок на большом зеленом блоке

по всему миру

Мы обнаружили, что DALL · E правильно реагирует на некоторые типы относительных позиций, но не на другие. Иногда кажется, что варианты «сидеть» и «стоять впереди» работают, «сидеть внизу», «стоять сзади», «стоять слева от» и «стоять справа от» — нет. DALL · E также имеет более низкий процент успеха, когда его просят нарисовать большой объект, расположенный поверх меньшего, по сравнению с другим способом.

Иногда кажется, что варианты «сидеть» и «стоять впереди» работают, «сидеть внизу», «стоять сзади», «стоять слева от» и «стоять справа от» — нет. DALL · E также имеет более низкий процент успеха, когда его просят нарисовать большой объект, расположенный поверх меньшего, по сравнению с другим способом.

стопка из 3 кубиков. красный куб находится сверху, сидящий на зеленом кубе. зеленый куб находится посередине, он сидит на синем кубе. синий куб находится внизу.

по всему миру

Мы обнаружили, что DALL · E обычно генерирует изображение с одним или двумя объектами, имеющими правильные цвета.Однако только несколько образцов для каждого параметра имеют тенденцию иметь ровно три объекта, окрашенных точно так, как указано.

смайлик пингвина в синей шляпе, красных перчатках, зеленой рубашке и желтых штанах

по всему миру

Мы обнаружили, что DALL · E обычно создает изображение с двумя или тремя предметами одежды правильного цвета. Однако лишь в нескольких образцах для каждой настройки обычно присутствуют все четыре предмета одежды указанных цветов.

Однако лишь в нескольких образцах для каждой настройки обычно присутствуют все четыре предмета одежды указанных цветов.

Хотя DALL · E действительно предлагает некоторый уровень управляемости над атрибутами и положением небольшого количества объектов, вероятность успеха может зависеть от того, как сформулирован заголовок. По мере того, как вводится больше объектов, DALL · E склонен сбивать с толку ассоциации между объектами и их цветами, и вероятность успеха резко снижается. Мы также отмечаем, что DALL · E хрупкий в отношении перефразирования заголовка в этих сценариях: альтернативные, семантически эквивалентные заголовки часто не дают правильных интерпретаций.

Визуализация перспективы и трехмерности

Мы обнаружили, что DALL · E также позволяет управлять точкой обзора сцены и 3D-стилем, в котором сцена визуализируется.

вид капибары, сидящей в поле, крупным планом

по всему миру

Мы обнаружили, что DALL · E может рисовать каждого из животных в разных ракурсах. Некоторые из этих видов, например «вид с воздуха» и «вид сзади», требуют знания внешнего вида животного с необычных ракурсов.Другие, такие как «очень крупный план», требуют знания мельчайших деталей кожи или шерсти животного.

Некоторые из этих видов, например «вид с воздуха» и «вид сзади», требуют знания внешнего вида животного с необычных ракурсов.Другие, такие как «очень крупный план», требуют знания мельчайших деталей кожи или шерсти животного.

капибара, состоящая из вокселей, сидящих в поле

по всему миру

Мы обнаружили, что DALL · E часто может изменять поверхность каждого из животных в соответствии с выбранным 3D-стилем, например, «пластилин» и «сделано из вокселей», и визуализировать сцену с правдоподобным затемнением в зависимости от расположения объекта. солнце. «Рентгеновский» стиль не всегда работает надежно, но он показывает, что DALL · E может иногда ориентировать кости внутри животного в правдоподобных (хотя и не анатомически правильных) конфигурациях.